Der EU AI Act – Verordnung über Künstliche Intelligenz

Der EU AI Act bewegt die Gemüter: Kritiker sehen ihn als Regulierungsmonster, die Macher loben ihn als Leuchtturm der globalen KI-Regulierung, der die Innovation fördern wird. Manche Unternehmen haben schon mit seiner Umsetzung begonnen, obwohl die meisten seiner Regelungen noch einige Zeit nicht gelten werden. Immerhin kann er auch Unternehmen in der Schweiz betreffen. Eine erste Kommentierung.

Der "EU AI Act" (AIA) oder zu Deutsch die "Verordnung über künstliche Intelligenz" der Europäischen Union (Verordnung (EU) 2024/1689) ist am 12. Juli 2024 im Europäischen Amtsblatt publiziert worden und am 1. August 2024 in Kraft getreten. Zuweilen ist auch vom "KI-Gesetz" der EU die Rede. Es wird bis zu 36 Monate dauern, bis all seine Bestimmungen gelten. Es zeichnet sich allerdings schon jetzt ab, dass er weit über die Europäische Union hinaus Wirkung entfalten wird. Wer einen Service oder ein Produkt mit künstlicher Intelligenz (KI) einsetzt, wird sich daran orientieren, jedenfalls wenn er auf Abnehmer in der EU oder auf dem Weltmarkt hofft. Dem ging ein mehrjähriges Tauziehen voraus, das zuletzt im Februar 2024 in einem vorläufig finalen Text endete.

1. Regelungskonzept

Der AIA ist – wie die EU-Datenschutz-Grundverordnung (DSGVO) – als Verordnung direkt anwendbares EU-Recht. Die Durchsetzung erfolgt teilweise in den Mitgliedstaaten (die jeweils eine Marktaufsichtsbehörde sowie eine Behörde zur Regelung der Verfahren der Stellen zur Beurteilung der Produktekonformität bezeichnen müssen), teilweise zentral (so ist die EU-Kommission für General Purpose AI Models zuständig).

Wie bei der DSGVO gibt es zentrale Institutionen z.B. das "European Artificial Intelligence Board" (EAIB), für welches jeder Mitgliedstaat einen Delegierten bestellt. Es soll ferner ein "Scientific Panel of Independent Experts" geschaffen werden. Das zentrale "AI Office" soll als Teil der Europäischen Kommission die Marktaufsichtsbehörden unterstützen, aber auch Templates zur Verfügung stellen und beispielsweise bei der Einhaltung der Vorgaben im Zusammenhang mit Allzweck-KI-Modellen mitwirken. Der Europäischen Kommission kommen auch unmittelbar Aufsichtsaufgaben zu.

Ob und wann der AIA nicht nur für EU-Mitgliedstaaten, sondern auch für die EWR-Staaten gelten wird, ist noch nicht klar. Der AIA gilt für private Organisationen wie auch für Behörden, welche die jeweiligen Voraussetzungen erfüllen. Ausnahmen gelten für die Bereiche Militär, Verteidigung und nationale Sicherheit, da diese den Mitgliedsstaaten noch weitgehend exklusiv vorbehalten sind.

Der AIA ist zwar lang (ca. 140 Seiten mit den Erwägungen und Anhängen) und – wie fast jeder EU-Erlass – mühsam in der Lektüre, aber nicht besonders kompliziert. Kurz:

- Es wird zwischen "AI Systems" (AIS, KI-Systeme) und "General Purpose AI Models" (GPAIM, was mit "Allzweck-KI-Modellen" übersetzt werden könnte – gemeint sind primär Modelle für generative KI wie etwa "GPT" oder "Llama") unterschieden.

- Es wird der persönliche und örtliche Geltungsbereich definiert, wobei vor allem unterschieden wird zwischen Anbietern von AIS und GPAIM ("Provider") und Betreibern der AIS ("Deployer").

- Einige wenige KI-Anwendungen werden verboten.

- Einige KI-Anwendungen werden als "hohes Risiko" definiert; sie werden über die betreffenden AIS reguliert ("High-Risk AI System", HRAIS): Für ein HRAIS müssen gewisse Anforderungen erfüllt sein (z.B. Qualitäts- und Risikomanagement, Dokumentation, Konformitätserklärung), um deren Einhaltung sich vor allem die Provider kümmern müssen; einige wenige Pflichten werden auch Deployern auferlegt. Es wird geschätzt, dass nur etwa fünf bis zehn Prozent aller AIS in diese Kategorie fallen werden; wir gehen davon aus, dass es in den meisten Unternehmen noch weniger sein werden, da die meisten Unternehmen einen Bogen um HRAIS machen werden – jedenfalls, in der Rolle eines Anbieters.

- Für alle anderen AIS werden einige allgemeinere Pflichten sowohl für Provider wie auch für Deployer definiert, primär zur Transparenz.

- Bei den GPAIM wird unterschieden zwischen:

- gar nicht erfasst (sehr wenige Fälle),

- "normal" (mit einigen Pflichten für die Provider) und

- "systemische Risiken" (mit zusätzlichen Pflichten für die Provider).

- Die Europäische Kommission führt ein zentrales Register der HRAIS, und es gibt diverse Regelungen (inklusive Meldepflichten), um Zwischenfälle im Zusammenhang mit HRAIS im Blick zu behalten und darauf bei Bedarf zu reagieren.

- Mit der Durchsetzung sind diverse nationale und EU-weite Behörden beschäftigt. Es entsteht ein kompliziertes Geflecht an Zuständigkeiten und Abstimmungsverfahren.

- Es sind begleitende Instrumente vorgesehen, wie etwa

- "regulatory sandboxes": (Recht, bei der Entwicklung neuer AIS für frühe Rechtssicherheit Aufsichtsbehörden einbeziehen zu dürfen),

- Regelungen für das Testen von AIS in der "echten Welt",

- Verhaltenskodizes und

- diverse Bestimmungen zur Schaffung von Standards, Benchmarks und Templates. Wie relevant sie in der Praxis wirklich sein werden, wird sich zeigen. Den grössten praktischen Nutzen dürften die Templates haben, welche insbesondere das AI Office erstellen soll. Je nachdem, wie praxisnah und detailliert sie ausfallen, werden sie die Compliance der Unternehmen entweder erschweren oder erleichtern. Die "regulatory sandboxes" wiederum dürften eher ein Schlag ins Wasser sein: Es ist nicht wirklich zu erkennen, wie sie die Innovation fördern sollten, auch wenn das ihr erklärtes Ziel ist. Es entspricht allgemeiner Erfahrung, dass ein frühzeitiger Einbezug von Aufsichtsbehörden bei neuen Techniken die Innovation leider oft behindert denn fördert, weil diese naturgemäss selbst über weniger technische und praktische Erfahrungen in den relevanten Fragen verfügen und die Tendenz haben, bei der Auslegung von gesetzlichen Vorgaben strengere Massstäbe als vom Gesetzgeber angedacht anzuwenden. Dies hat die Umsetzung der DSGVO bewiesen; bis heute versuchen zahlreiche EU-Aufsichtsbehörden den Datenschutz deutlich über das gesetzliche Niveau hinaus auszubauen. Es zeichnet sich ab, dass manche von ihnen auch für die Umsetzung des AIA zuständig sein werden. Insofern wird der AIA nicht wie von der Kommission erhofft oder propagiert die Innovation im Bereich KI fördern, sondern sie in erster Linie verteuern und erschweren und damit die Markteintrittshürden für kleine Unternehmen erhöhen. Positiv ist an der Regulierung des AIA aus dem Blickwinkel der Innovation primär, dass sie für gewisse Rechtssicherheit sorgt.

- Es gibt einige Bestimmungen zur Durchsetzung, die Untersuchungs- und Eingriffsbefugnisse durch die Aufsichtsbehörden, Administrativ-Bussen (meist etwas geringer als bei der DSGVO) und ein Auskunftsrecht für Personen in der EU, über die mit Hilfe einer KI Entscheidungen getroffen wurden.

- Bestimmungen zum Inkrafttreten und ganz wenige Übergangsbestimmungen.

GPAIM sind auffällig milder und weniger eingehend reguliert als AIS und zudem separat abgehandelt, was unter anderem dem Umstand geschuldet ist, dass sie erst im Laufe der Beratungen als Regulierungsobjekt aufgenommen wurden; der ursprüngliche Entwurf des AIA geht auf Mitte 2021 zurück, also noch vor dem Hype um "ChatGPT" & Co. und den diesen Anwendungen zugrunde liegenden grossen Sprachmodelle oder "Large Language Models" (LLM). Das GPT LLM ist ein klassisches Beispiel für ein GPAIM.

Der AIA ist primär eine Marktzugangs- und Produkteregulierung, wie wir sie bei diversen Produkten mit erhöhten Risiken (z.B. Medtech) kennen. Sie grenzt den AIA zur DSGVO ab, welche primär Verhalten (Bearbeiten von Personendaten) und Betroffenenrechte reguliert. Es gibt zwar einige wenige allgemeine Verhaltensgrundsätze für den Einsatz von KI und ein Betroffenenrecht, aber sie sind punktuell auf bestimmte Anwendungsfälle ausgerichtet; auch die "verbotenen" KI-Anwendungen sind im Grunde sehr eng definiert. Es wird vor allem reguliert, welche Begleitmassnahmen für als besonders risikoreich beurteilte AIS getroffen werden müssen, und es wird geregelt, wie sie in Verkehr gebracht, eingesetzt und überwacht werden müssen.

Manche HRAIS werden dabei AIS sein, die Teil bereits regulierter Produkte sind, in welchen Fällen viele der vom AIA vorgesehenen Pflichten in ähnlicher Weise schon gelten; der AIA verweist auch regelmässig auf diese und sieht eine kombinierte Umsetzung (etwa was das Risiko- und Qualitätsmanagement, die Dokumentation und die Konformitätserklärungen betrifft, aber auch in Bezug auf die behördliche Aufsicht). Offensichtlich war der Gesetzgeber bemüht, die Bürokratie nicht allzu sehr ausufern zu lassen; ob ihm dies gelungen ist, erscheint allerdings fraglich. Immerhin ist durchgängig erkennbar, dass ein risikobasierter Ansatz gelten soll. Viele der Vorgaben sind eher generisch gehalten, wodurch in der Praxis Spielraum bei der Umsetzung besteht – soweit übereifrige Aufsichtsbehörden hier nicht wie bei der DSGVO ihr Unwesen treiben werden.

Der AIA hält immer wieder fest, dass er zusätzlich zum bestehenden Recht gilt, d.h. dieses in keiner Weise einschränken will. Das betrifft insbesondere die DSGVO. Der AIA stellt für sich auch keine Rechtsgrundlage für die Bearbeitung von Personendaten dar, mit einigen wenigen Ausnahmen – namentlich den Fall, in welchem es für Tests von HRAIS (aber nicht anderen AIS) hinsichtlich eines möglichen "Bias" unbedingt erforderlich (sinnvoll genügt nicht) ist, besondere Kategorien von Personendaten zu bearbeiten. In der Sache selbst enthält er kaum Regelungen im Bereich des Datenschutzes; es fällt aber auf, dass mit dem EU Data Protection Supervisor einer Datenschutzbehörde die Aufgabe der KI-Marktaufsicht über die Institutionen der EU zukommen soll. Inwiefern die EU-Mitgliedstaaten die KI-Marktaufsicht ebenfalls ihren bereits bestehenden Datenschutzbehörden anvertrauen werden, wird sich zeigen. Wir schätzen, dass dies in ungefähr der Hälfte der Fälle so sein wird.

Was ebenfalls auffällt, ist, dass der Gesetzgeber offenbar einige Mühe hatte, den staatlichen Einsatz von AIS im Bereich der Strafverfolgung und ganz speziell bei Systemen zur biometrischen Fern-Identifizierung von Menschen in der Öffentlichkeit zu regeln (also z.B. anhand ihres Gesichts oder Gangs über Kameras in der Öffentlichkeit). Der Einsatz dieser Systeme ist in gewissen Fällen erlaubt und im AIA viel ausführlicher geregelt als alle anderen Anwendungen (wobei zu beachten ist, dass der Bereich der Wahrung der nationalen Sicherheit von vornherein vom Geltungsbereich des AIA ausgenommen ist). Für Unternehmen und betroffene Personen in der Schweiz wird dies weniger relevant sein. Darum gehen wir hier nicht näher auf diese und andere staatliche Anwendungen ein.

2. Geltungsbereich: Was ist ein KI-System?

Der Geltungsbereich des AIA ist leider in verschiedener Hinsicht alles andere als klar – und er ist überaus breit definiert.

Das beginnt bereits mit der Definition von AIS. Sie enthält fünf Elemente, wovon drei auf fast jede IT-Anwendung zutreffen, nämlich vereinfacht gesagt: dass ein System (i) maschinenbasiert ist, (ii) aus einem Input abgeleitet wird, wie ein Output zu erzeugen ist, und (iii) dass dieser Output etwas ausserhalb der Anwendung bewirken kann. Das trifft wohl auf jede klassische Tabellenkalkulation oder Bildbearbeitungssoftware zu, da auch sie aus Input (Zahlen und Formeln, Bilder) einen Output generieren (Ergebnis der Berechnungen, mit Filtern bearbeitete Bilder) und diese etwas bewirken können. Auch jeder Chip hat Kanäle für Input und solche für Output. Das Kriterium des möglichen Einflusses auf die Umwelt erscheint ebenfalls uferlos, weil ein IT-System, das keinen Einfluss auf seine Umwelt hat, sinnfrei sein wird.

Hinzu kommen als weitere Kriterien: Dass (iv) das System sich auch nach seiner Implementierung anpassen kann (es ist ausdrücklich die Rede von "sein kann" bzw. "may" – die Lernfähigkeit eines Systems nach seiner Inbetriebnahme ist nach unserem Verständnis also kein zwingendes Kriterium; wäre es zwingend, wären sehr viele KI-Anwendungen, die wie "ChatGPT" klar erfasst sein sollen, keine AIS mehr, weil ihre Modelle nicht laufend angepasst werden, sondern den Benutzern quasi im "eingefrorenen" Zustand übergeben werden). Und dass das System (v) so ausgestaltet ist, dass es sich mehr oder weniger autonom verhält.

Dieses letzte Element der Definition, also die mindestens teilweise Autonomie, erscheint somit als das einzige wirklich relevante Unterscheidungsmerkmal, das KI-Systeme von allen anderen Systemen unterscheidet. Allerdings ist auch nicht vollständig klar, was "Autonomie" bedeutet. Im Kern soll es wohl um eine Abgrenzung zu Systemen gehen, deren Output aus dem Input vollständig nach von Menschen formulierten Regeln erzeugt wird, also einem vollständig (d.h. statisch oder deterministisch) ausprogrammierten System ("Wenn-Dann-Systeme") – im Gegensatz zu Systemen, die beispielsweise eine Mustererkennung auf Basis eines Trainings betreiben. Es ist nicht mehr eine statische bzw. deterministische Programmierung, die alleine bestimmt, welcher Output aus welchem Input resultiert, sondern ein Vorgang des maschinellen Lernens; die Entscheidlogik stammt nur indirekt vom Menschen, welcher der Maschine erklärt, wie sie lernen und basierend auf dem Gelernten im Einzelfall selbst entscheiden muss; es wird also nicht jeder Entscheid vom Menschen vorgegeben. In diese Richtung äussern sich auch die Erwägungen. Während die meisten bei deterministischem Code an solchen von menschlichen Programmierern denken, kann dieser allerdings auch von einer KI programmiert sein. Ein von einer KI deterministisch programmiertes System ist somit kein AIS, weil ihm die Autonomie fehlt. Das führt zur spannenden Frage, wie auf diese Weise die Regelungen des AIA umgangen werden könnten, indem z.B. ein AIS beauftragt wird, basierend auf seinem Wissen ein System zu entwickeln, das zwar über eine deterministische Programmierung verfügt, aber dennoch so komplex ist, dass wir Menschen seine Funktion bzw. Entscheidungslogik nicht mehr verstehen (wir gehen davon aus, dass sich die Verfasser des AIA über solche Dinge keine Gedanken gemacht haben; hätten sie es getan, hätten sie auch dies ausgeschlossen). Vorderhand werden wir aber davon ausgehen müssen, dass die Anwendbarkeit des AIA verhindert werden kann, indem nur Systeme eingesetzt werden, die nicht autonom im vorstehenden Sinne agieren, auch wenn sie zum selben Ergebnis führen oder ebenso problematische Dinge tun wie ein AIS.

Vereinfacht gesagt ist also jedes IT-System, welches seine Funktion (genauer: wie es aus einem bestimmten Input einen bestimmten Output erzeugt) nicht nur auf Basis einer Vorprogrammierung erfüllt, sondern mindestens teilweise auf Basis eines Trainings, ein AIS. Hiermit schliesst sich auch der Kreis jener, die das "Schliessen" von einem Input auf einen Output ("ableiten", "inference") als das wesentliche Kriterium erachten; es ist dasselbe Verständnis, nur aus einem anderen Blickwinkel. Wir erachten nicht die Tatsache der Ableitung als entscheidend, sondern die Art und Weise, wie sie geschieht – eben mindestens teilweise basierend auf einem Training, nicht einer klassischen Programmierung, und damit eben mindestens teilweise autonom.

Dies macht den Fächer enorm breit. Erfasst ist beispielsweise jedes System, das ein neuronales Netzwerk oder sonst ein Verfahren des maschinellen Lernens beinhaltet, um gestützt darauf Output zu generieren bzw. Entscheide zu treffen. AIS sind somit selbst so banale Anwendungen wie eine Zeichenerkennung (OCR) in einem Kopierapparat oder PDF-Leseprogramme, der Einsatz eines Fingerabdrucksensors an einem Computer oder Mobiltelefon zu dessen Entsperrung oder der Algorithmus, der in einer Internet-Suchmaschine unsere Eingaben interpretiert, um diese in einen passenden Suchbefehl umzuwandeln. An vielen Orten werden Unternehmen und erst recht die "normalen" Anwenderinnen und Anwender gar nicht realisieren, dass sie schon seit vielen Jahren mit AIS arbeiten. Selbst der Einsatz vergleichsweise einfache und übersichtliche Methoden wie etwa "Random Forest" machen aus einem IT-System ein AIS, jedenfalls wenn "Autonomie" wie in den Erwägungen dargelegt so verstanden wird, dass ein System seine Entscheide nicht ausschliesslich nach einer von einem Programmierer getroffenen Entscheidung fällt. Wo genau die Abgrenzung KI/Nicht-KI zu ziehen ist, ist allerdings nicht trivial. Verwendet eine Software das Verfahren der "linearen Regression", um z.B. anhand von bisherigen Temperatur- und Besucherzahlen eines Freibads vorherzusagen, bei welcher Temperatur wieviele Gäste zu erwarten sind, so wird das kaum jemand als KI bezeichnen, sondern als reine Statistik: Die bisherigen Erfahrungswerte und Prognosetemperatur sind der Input für die Formel des Programms und die berechnete Gästezahl deren Output; es könnte auch gesagt werden, dass "Training" und Auswertung erst durch den Anwender erfolgt und nicht denjenigen, der das System bereitstellt. In Tat und Wahrheit können allerdings auch klassische Methoden des Machine Learnings als mathematische Funktionen beschrieben werden, nur sind sie oft komplexer. Eine scharfe Abgrenzung ermöglicht also das Kriterium der "Autonomie" bzw. der Differenzierung Training vs. Programmierung nicht.

Während der AIA die allermeisten AIS nicht reguliert, dürfte sich seine Definition dessen, was "KI" ist, trotz der Unschärfen vielerorts durchsetzen; er ist zudem ähnlich zur Definition von KI der OECD. Umso wichtiger wird es sein, dass Unternehmen und Aufsichtsbehörden bei der Regulierung von KI sich der Breite des Begriffs bewusst sind, einschliesslich der Tatsache, dass er sehr viele Anwendungen umfasst, an die sie beim Verfassen ihrer Regelwerke gar nicht denken und die dafür auch nicht passen.

Die Definition von GPAIM ist noch diffuser als jene von AIS. Was ein "AI Model" ist, wird gar nicht gesagt. Ein "general purpose" (oder auf Deutsch "Allzweck-") KI-Modell wird zu einem solchen, wenn es für viele unterschiedliche Aufgaben eingesetzt werden kann und in dieser allgemeinen Form auf den Markt gebracht wird, so dass es in eine Vielzahl von Systemen und Anwendungen integriert werden kann.

Eine Praxisbemerkung noch zum Schluss: Die meisten Bestimmungen im AIA beziehen sich jeweils auf ein AIS, also ein "System". Die meisten dieser Bestimmungen im AIA verlangen jedoch zusätzlich, einen bestimmungsgemässen Einsatzzweck dieses Systems, also beispielsweise für eine bestimmte Hoch-Risiko-Anwendung (z.B. Berechnung eines Bonitätsscore). In der Praxis wird die Kombination allerdings nicht mehr als System, sondern als Anwendung oder "Use Case" bezeichnet. Die Unterscheidung wird insofern von praktischer Relevanz sein, als im Unternehmen bei guter Governance jeweils entsprechende Verzeichnisse ihrer KI-Aktivitäten führen werden, und sich hierbei die Frage stellt, ob diese nach Systemen oder eben nach Anwendungen geführt werden. Auch wenn der AIA nach Systemen unterscheidet, erweist sich für die Zwecke der KI-Governance häufig eine Inventarisierung nach Anwendung, d.h. nach Use Case, als nützlicher, weil ein System ohne Anwendung i.d.R. nicht angeschafft wird (selbst generische Tools wie "ChatGPT" haben eine solche), die Anwendung die Rechtsfolgen definiert, und jede Anwendung typischerweise intern auch einen eigenen "Eigner" hat.

3. Geltungsbereich: Wer gilt als Provider?

Die beiden wichtigsten Rollen, die eine Organisation unter dem AIA separat oder zugleich haben kann, sind wie bereits erwähnt jene des Providers (zu Deutsch der "Anbieter") und jene des Deployers (zu Deutsch der "Betreiber"). Es gibt zwar weitere Rollen wie die der Importeure ("Einführer"), der Distributoren ("Händler") und Produktehersteller sowie des EU-Vertreters ("Bevollmächtigter"), aber sie können letztlich dem Provider zugerechnet werden. Die Aufsichtsbehörden können gegen alle vorgehen, und alle müssen mit ihnen kooperieren.

Es ist von zentraler Bedeutung, dass ein Unternehmen für jedes AIS oder GPAIM, mit dem es zu tun hat, ermittelt, welche Rolle es diesbezüglich hat, da sich aus dieser Rolle die Pflichten unter dem AIA ergeben. Die meisten Pflichten werden dabei dem Provider auferlegt (siehe unten).

Provider ist in erster Linie derjenige, der (i) ein AIS oder GPAIM entwickelt (selbst oder im Auftrag), und (ii) der es unter seinem Namen oder seiner Marke in den Verkehr bringt oder in Betrieb nimmt:

- Inverkehrbringen ("placing on the market") bezieht sich gemäss Definition nur auf den EU-Markt und erfasst nur die erste Bereitstellung im Markt.

- Inbetriebnahme ("putting into service") bezieht sich ebenfalls nur auf das Gebiet der EU. Gemeint ist die Bereitstellung des AIS zum Erstgebrauch (d.h. erstmaligen Gebrauch) direkt an einen Deployer, aber auch zum (erstmaligen) Eigengebrauch (für GPAIM gilt diese Variante nicht, da sie nach der Konzeption des AIA nur eine Vorstufe eines AIS sind).

- In beiden Fällen ist vermutlich eine Ausrichtung auf die EU gemeint, d.h. sie muss das Ziel sein; ein "non-intentional spill-over" genügt nicht.

- Keine Rolle spielt dabei, ob dies entgeltlich oder unentgeltlich geschieht.

Bevor das geschieht, ist die Forschung, die Entwicklung und das Testen an und von AIS vom Geltungsbereich des AIA ausgenommen (Gegenausnahme sind einzig "Freilandversuche", also das Testen in der "realen Welt"; für sie gibt es ein separates Kapitel im AIA).

Diese Definition hat Folgen. Wer ein von ihm entwickeltes AIS nicht in der EU in den Verkehr bringt und auch nicht für den dortigen Eigen- oder Fremdeinsatz liefert, kann jedenfalls gemäss Wortlaut kein Provider sein und unterliegt somit nicht dem AIA, selbst wenn sein AIS den Weg dorthin findet oder dort Wirkung erzielt. Das gilt selbst für Unternehmen, die sich in der EU befinden. Das erscheint aufgrund des Wortlauts der Definitionen klar, sorgt aber für eine Lücke, weil der räumliche Geltungsbereich an sich weiter gefasst worden ist: Gemäss diesem sollen auch jene Provider erfasst sein, die sich im Ausland befinden, sofern der Output des AIS bestimmungsgemäss in der EU genutzt wird. Diese Regelung soll die Umgehung des AIA durch im Ausland ver- und betriebene AIS mit EU-Wirkung verhindern, greift aber gemäss Wortlaut bei Providern ins Leere, weil die Legaldefinition des Providers bereits einen EU-Marktbezug voraussetzt. Es wird interessant sein zu sehen, wie die Aufsichtsbehörden mit diesem gesetzgeberischen Versehen umgehen werden, da die Absicht des Gesetzgebers zwar klar ist, der Wortlaut aber ebenso.

Einen Anwendungsbereich für die vorstehende Regelung gibt es aber so oder so: Als Provider gilt ausnahmsweise auch jeder, der sich die Rolle des Providers quasi anmasst. Gemeint sind jene, die (i) ihren Namen oder ihr Markenzeichen an einem HRAIS anbringen (was auch immer dies bedeutet), das schon auf dem EU-Markt ist, (ii) ein solches HRAIS wesentlich ändern (es aber weiterhin ein HRAIS ist) oder (iii) ein AIS auf dem EU-Markt entgegen seiner ursprünglichen Bestimmung so verändern bzw. einsetzen, dass es zum HRAIS wird. Ein Beispiel ist die Verwendung eines Allzweck-Chatbots für eine Hoch-Risiko-Anwendung (z.B. wenn "ChatGPT" in der EU zur Analyse von CVs von Stellenbewerbern genutzt wird). Der ursprüngliche Provider gilt dann nicht mehr als solcher. In diesem Fall wird die Spezialregelung solche Provider erfassen, falls diese ihren Sitz ausserhalb der EU haben, der Output der KI aber bestimmungsgemäss in der EU genutzt wird. Ist dies nicht der Fall, stellt sich wiederum die Frage, ob diese "abgeleiteten" Provider noch in den Geltungsbereich des AIA fallen, wenn sie selbst das AIS nicht auf den EU-Markt gebracht und es dort auch nicht zum Einsatz gebracht haben. Das wäre eine weitere Lücke im AIA.

In der Literatur wurde teilweise vertreten, dass der AIA jedes AIS reguliere, welches Personen in der EU betrifft, direkt oder indirekt. Dies trifft nach der hier vertretenen Ansicht nicht zu. Es ist zwar richtig, dass der AIA auf alle betroffenen Personen ("affected persons") in der EU ausdrücklich Anwendung findet. Das bedeutet jedoch nicht automatisch, dass er auch auf alle Provider, Deployer und weitere Personen Anwendung findet; ihr persönlicher und örtlicher Geltungsbereich ist vom AIA separat definiert. Wäre automatisch jedes AIS (mitsamt seinen Providern, Deployern und weiteren beteiligten Stellen) im Geltungsbereich des AIA, wären die vorstehend diskutierten differenzierten Regeln gar nicht nötig gewesen. Die Aufnahme der betroffenen Personen im Geltungsbereich des AIA ist vielmehr nötig, damit sie ihre (wenigen) Rechte unter dem AIA geltend machen können.

Nur für HRAIS und nur rudimentär geregelt sind die Fälle, in denen ein AIS von mehreren Stellen stammt bzw. wenn das AIS eines Providers ein AIS eines anderen Providers enthält. In diesen Fällen soll mit dem Sublieferanten ein Vertrag abgeschlossen werden, der seinem Kunden als Provider die Einhaltung des AIA ermöglicht; der Sublieferant wird vermutlich nach Massgabe seiner eigenen Markthandlungen selbstständig erfasst sein. Wer wiederum ein AIS in ein anderes Produkt verbaut, welches er dann unter eigenem Namen im EU-Markt anbietet oder in der EU in Verkehr bringt, gilt unter dem AIA als Produkthersteller ("Product Manufacturer") und – falls es sich um ein HRAIS handelt (z.B. weil es eine Sicherheitsfunktion eines regulierten Produkts übernimmt) – als dessen Provider im Sinne des AIA. Mit anderen Worten: Der Provider kann nicht nur derjenige sein, der ein AIS (i) als erstes entwickelt, sondern auch (ii) derjenige, der es weiterentwickelt und in ein übergeordnetes AIS oder sonstiges Produkt verbaut sowie (iii) wer sich gemäss (i) oder (ii) darstellt.

Was passiert, wenn jemand ein AIS (mit)entwickelt, es aber nicht unter seinem Namen oder seiner Marke, sondern derjenigen eines anderen in der EU in Verkehr bringt oder in Betrieb nimmt, ist ebenfalls nicht ganz klar. Ein Provider kann diese Stelle formal gesehen nicht sein, weil ein zwingendes Kriterium der Legaldefinition nicht erfüllt ist. Der AIA kennt zwar gewisse Formen der "gemeinsamen" Verantwortlichkeit, sie geht aber nicht so weit wie im Datenschutz, wo es auch möglich ist, dass zwei Stellen für eine Verarbeitungsaktivität gemeinsam verantwortlich sein können, obwohl sie arbeitsteilig zusammenwirken. Etwas ähnliches müsste an sich auch hier gelten, nur fehlt soweit ersichtlich die Rechtsgrundlage dafür; es ist nur das Zusammenwirken mehrerer Stellen geregelt, bei denen jeder auch für sich alleine als Provider gilt. Über Hilfskonstruktionen kann der Fall jedoch gelöst werden:

- Wer unbefugt den Namen oder die Marke eines anderen auf dem von ihm entwickelten AIS angibt und sich damit im Grunde anmasst, wird in Bezug auf die Verantwortlichkeit als Provider dementsprechend wohl so behandelt werden, als wäre es auch sein eigener Name oder seine eigene Marke. Er müsste als Provider betrachtet werden – schon nur aufgrund des Prinzips von Treu und Glauben.

- Wer hingegen an einem AIS (mit)entwickelt, jedoch befugt den Namen oder die Marke eines anderen anbringt, kann unseres Erachtens mit guten Gründen vertreten, dass er lediglich für den anderen gehandelt hat, der als Provider gilt; die Nennung seines Namens oder das Anbringen seiner Marke – oder die Erlaubnis an einen Dritten, dies zu tun – ist gewissermassen die Erklärung, die Verantwortung des Providers für das AIS zu übernehmen.

4. Geltungsbereich: Wer gilt als Deployer?

Anwender von AIS werden unter dem AIA als Deployer erfasst und mit einigen wenigen Pflichten belegt (dazu unten). Deployer ist, wer ein AIS in eigener Verantwortung ("under its authority") einsetzt. Ausgenommen sind jene Personen, die ein AIS (nur) für persönliche, nicht berufliche Aktivitäten einsetzen ("personal non-professional activity", wobei auch hier die Gesetzesredaktion unsorgfältig erfolgte – die Ausnahme existiert gleich auf zwei Ebenen und ist leicht verschieden formuliert).

Das Kriterium "under its authority" grenzt den blossen Genuss eines AIS bzw. dessen Output vom Einsatz eines AIS als eigenes Werkzeug ab. Hier wird eine gewisse Kontrolle erforderlich sein, damit das Kriterium erfüllt ist, denn Kontrolle führt zur Verantwortung. Wenn ein Benutzer auf einer Website einen Kundendienst-Chatbot benutzt, dann hat er diese Kontrolle nicht; jedenfalls ist dies nicht so vorgesehen. Er kann Fragen stellen und das Unternehmen steuert, wie der Chatbot sie beantwortet. Anders wäre es erst, wenn es dem Benutzer gelingt, den Chatbot zu "hacken" und zu nicht geplanten Äusserungen zu bringen. Stellt ein Unternehmen hingegen seinen Kunden im Rahmen einer Dienstleistung eine KI-Funktionalität zur Verfügung, die diese bestimmungsgemäss hinsichtlich ihres Einsatzes in gewissen Grenzen kontrollieren sollen und können, dann dürfte das Kriterium "under its authority" wohl erfüllt sein. Bietet eine Firma wie OpenAI ihren Kunden den Chatbot "ChatGPT" an, so unterscheidet sich dieser vom erwähnten Kundendienst-Chatbot dadurch, dass es der Kunde von OpenAI ist, der dem Chatbot die Anweisungen erteilen soll, worüber er sprechen soll – und nicht mehr das Unternehmen, das ihn betreibt. Wo genau die Grenze verläuft (z.B. bei themenspezifischen Chatbots), ist freilich auch hier noch nicht klar. Es bietet sich an, hier auf die Praxis zum vergleichbaren Konzept des "Verantwortlichen" bzw. "Controllers" im Datenschutz zurückzugreifen, das aus der Kontrolle über den Zweck und die (wesentlichen) sonstigen Parameter einer Datenbearbeitungsaktivität auch die diesbezügliche (alleinige oder gemeinsame) Verantwortung ableitet.

In den räumlichen Geltungsbereich fallen all jene Deployer, die entweder in der EU sind (ob mit einer Niederlassung oder weil sie sich als natürliche Personen dort aufhalten) oder, falls nicht, diejenigen, deren Output der von ihnen betriebenen AIS in der EU "verwendet" wird. Letztere Regel soll gemäss den Erwägungen die Umgehung des AIA durch Anbieter in Drittländern (wie der Schweiz oder den USA) verhindern, die Daten in der EU sammeln oder von dort erhalten, sie mit AIS im EU-Ausland bearbeiten und das Ergebnis zur Nutzung in die EU zurücksenden, ohne, dass das AIS in der EU auf den Markt gebracht oder dort zum Einsatz gebracht wird. Das Beispiel wirft selbst Fragen auf, da ein Unternehmen mit Sitz in der EU, welches ein Unternehmen im EU-Ausland bittet, in seinem Auftrag Daten mit einem AIS zu bearbeiten, wohl trotzdem als dessen Deployer gelten wird, so wie im Datenschutz die Handlungen des Auftragsbearbeiters dem Verantwortlichen zugerechnet werden. Viel relevanter dürfte die Ausnahmeregelung für jene Unternehmen sein, die sich im EU-Ausland befinden (z.B. in der Schweiz oder in den USA) und AIS für sich selbst einsetzen. So oder so soll die Regelung vom Einsatz des AIS betroffene natürliche Personen auf dem Gebiet der EU schützen. Gemäss den Erwägungen ist es erforderlich, dass die Verwendung des KI-Outputs in der EU beabsichtigt ("intended to be used in the Union") und nicht bloss zufällig war.

Was genau als "Verwendung" von KI-Output in der EU gilt, wird nicht näher ausgeführt. Ob es hierzu bereits genügt, dass im EU-Ausland erzeugter KI-Output eine Wirkung auf Personen in der EU hat, ist denkbar, aber unseres Erachtens eher fraglich. Einige Beispiele:

- Wer im EU-Ausland auf seiner Website KI-generierte Inhalte publiziert und diese (auch) auf ein Publikum in der EU ausrichtet, dürfte erfasst sein. Dasselbe gilt für KI-generierte Inhalte auf Werbeunterlagen, die auch Kunden in der EU ansprechen sollen.

- Erfasst sein dürfte ebenso das Unternehmen, das seinen Kunden im EU-Raum durch ein AIS generierte Texte sendet.

- Findet ein von einem AIS im EU-Ausland erstelltes Dokument zufällig seinen Weg auch in die EU, dann ist der Deployer des AIS noch nicht erfasst.

- Nicht erfasst sein dürfte hingegen ein zwar von einem Computer, aber weder direkt noch indirekt von einer KI generierter Inhalt.

- Die Möglichkeit, dass KI-Output auf dem Weg des datenschutzrechtlichen Auskunftsrechts in die EU gelangen kann, genügt unseres Erachtens ebenfalls nicht zur Anknüpfung; dazu kann es zwar kommen, es wäre aber in der Regel keine bestimmungsgemässe Verwendung.

- Der Einsatz eines HRAIS oder die Durchführung einer nach AIA verbotenen Praktik durch einen Schweizer Arbeitgeber in Bezug auf seine Schweizer Mitarbeitenden dürfte selbst dann nicht dem AIA unterliegen, wenn er Mitarbeitende aus der EU beschäftigt, den Output der KI aber nur am Sitz des Unternehmens in der Schweiz verwendet.

- Setzt der Arbeitgeber dafür jedoch eine Cloud bzw. einen Cloud-Provider in der EU ein, sieht die Rechtslage allenfalls anders aus: Ob die Auslagerung des Betriebs eines AIS an einen Provider mit Sitz oder Rechenzentrum in der EU bedeutet, dass auch der Output der AIS als dort "verwendet" gilt, ist noch unklar. Wir glauben, dass dies nicht der Fall ist bzw. sein darf: Mit Blick auf den primären Schutzzweck, nämlich den Schutz der Gesundheit, der Sicherheit und der Grundrechte von natürlichen Personen in der EU, kann die Auslagerung des IT-Betriebs in die EU für sich noch nicht genügen, weil alleine dadurch diese in keiner Weise tangiert sind. Es gibt keinen Bezug zwischen dem Ort der Bearbeitung bzw. des Providers und der betroffenen Personen. Das Kriterium der Verwendung des Outputs in der EU soll seinem Zweck nach jene Fälle abdecken, in denen der Output zwar ausserhalb der EU erzeugt wird, in der EU aber auf betroffene Personen "trifft". Das ist hier nicht der Fall. Eine Niederlassung wird mit der blossen Beauftragung eines Dienstleisters in der EU erst recht nicht begründet (so auch nicht unter der DSGVO). In den sekundären Schutzzielen des AIA werden auch der Schutz der Demokratie, des Rechtssystems und der Umwelt genannt, aber auch diese rechtfertigen nicht wirklich die Erweiterung des Geltungsbereichs; sie käme noch am ehesten bezüglich dem Schutzziel des Umweltschutzes im Hinblick auf den Energieverbrauch der Rechenzentren für KI in Frage, aber diesbezüglich enthält der AIA selbst keine wirklich relevanten Regeln. Zu beachten ist immerhin, dass der Provider, der im Rahmen seiner Cloud-Dienste auch KI-Funktionalitäten anbietet, selbst dem AIA unterliegen kann, auch wenn sein Kunde als Deployer dies nicht tut. Diesen Fall haben wir im Bereich der DSGVO ebenfalls bei Providern mit Sitz im EWR; sie unterliegen der DSGVO, ihre Schweizer Kunden aber möglicherweise nicht.

Ungeachtet der noch bestehenden Unklarheiten führt die Regelung zur Verwendung von KI-Output in der EU zu einer erheblichen extraterritorialen Wirkung des AIA. Dies bedeutet, dass sich auch viele Schweizer Unternehmen mit den vom AIA den Deployern auferlegten Kennzeichnungspflichten befassen sollten. In Bezug auf eine etwaige Rolle als Provider können sie sich hingegen wie erwähnt jedenfalls einstellen auf den Standpunkt stellen, dass sie nicht erfasst sind, wenn sie das AIS nicht in der EU in Verkehr bringen oder dort in Betrieb nehmen.

5. Weitere Abgrenzungsfragen für Unternehmen

Weitere Abgrenzungsfragen werfen die Rollendefinitionen des AIA insbesondere dort auf, wo Unternehmen AIS selbst weiterentwickeln, im Verkehr mit Dritten einsetzen oder innerhalb einer Unternehmensgruppe weitergeben.

Unklar ist, was als "Entwickeln" eines AIS ("develop") gilt. Liegt ein solches beispielsweise bereits vor, wenn ein Unternehmen ein kommerzielles KI-Produkt für seine eigene Anwendung parametrisiert (z.B. mit entsprechenden Systemprompts ausstattet), ein Fine Tuning des Models vornimmt oder in eine weitere Anwendung integriert (z.B. Einbau einer im Markt angebotenen Chatbot-Software in die eigene Website oder App)? Wäre dem so, würden viele Anwender selbst zum Provider werden, da die Legaldefinition des Providers auch denjenigen erfasst, der AIS zum Eigengebrauch ("for own use") zum Einsatz bringt, falls dieser Einsatz bestimmungsgemäss in der EU und unter eigenem Namen erfolgt. Ein solch weites Verständnis ist nach der hier vertretenen Auffassung zwar abzulehnen, aber es ist zu befürchten, dass die Aufsichtsbehörden hier ein breites Verständnis an den Tag legen werden und mindestens jene Handlungen als Entwickeln betrachten, welche über Prompting, Parametrisierung und das Liefern von sonstigem Input hinausgehen. Demnach wäre ein Fine Tuning des Modells eines AIS erfasst (weil gewissermassen das Trainingswissen und damit die Programmierung verändert wird), die Verwendung von "Retrieval Augmented Generation" (RAG) hingegen nicht (weil hier lediglich der Input verändert wird). Denkbar wäre auch ein Ansatz, der sich an der Gefahr orientiert, der vom Beitrag im Einzelfall ausgeht, was allerdings zu einer erheblichen Rechtsunsicherheit führen würde, weil dieselbe Handlung je nach Systemzweck zu einer unterschiedlichen Qualifikation desjenigen führen würde, der sie vornimmt. Dabei ist zu berücksichtigen, dass auch der Deployer bis zu einem gewissen Mass in der Pflicht bleibt.

Bis zur Klärung der Rechtslage ist es Unternehmen als Vorsichtsmassnahme zu empfehlen, beim Einsatz solcher AIS auch gegen aussen den Namen des Technologielieferanten anzugeben (z.B. "Powered by …" bei einem Chatbot, der auf der Website den eigenen Kunden als Service angeboten wird). So kann vertreten werden, dass das AIS – selbst wenn die Implementierung oder Optimierung als Entwicklung gelten sollte – nicht als unter eigenem Namen oder den eigenen Handelsmarken bzw. Markenzeichen zum Einsatz gebracht gilt ("under its own name or trademark"). Dies sollte jedoch mit Erlaubnis des Technologielieferanten erfolgen, da er bereit sein muss, die Rolle des Providers und die damit verbundene Verantwortlichkeit zu übernehmen (d.h. die Anpassungen ihm alleine zugerechnet werden). Eine weitere mögliche Vorsichtsmassnahme ist die Einschränkung der erlaubten Verwendung eines AIS auf Personen ausserhalb der EU, weil die Legaldefinition des Providers dann mutmasslich nicht mehr greift.

Unklar ist auch, wie die Weitergabe von KI-Services oder KI-Technologie innerhalb einer Gruppe von Unternehmen zu werten ist. Es sind hier verschiedene heikle Szenarien denkbar. Ein Szenario ist der Fall, in welchem die Gruppengesellschaft X ausserhalb der EU ein AIS vom Anbieter Y ausserhalb der EU einkauft und es dann den anderen Gruppengesellschaften auch in der EU zur Verfügung stellt. Ist das AIS bis dahin noch nicht auf dem EU-Markt eingeführt oder in der EU in Einsatz gebracht worden, kann X selbst ohne es weiterentwickelt zu haben zu dessen Händler ("Distributor") oder allenfalls sogar Einführer ("Importer") werden. Dies würde eine Reihe von Sonderpflichten mit sich bringen. Während X die Qualifikation als Einführer (und Provider) wohl verhindern kann, indem nur AIS in die EU weitergegeben werden, die dort schon auf dem Markt sind, schützt dies X nicht vor der Qualifikation als Händler. Hier kann immerhin vertreten werden, dass der Begriff voraussetzt, dass das Unternehmen Teil der in der Definition erwähnten Lieferkette ("supply chain") von Y ist und dass diese einen konzerninternen Vertrieb eines AIS an Gruppengesellschaften von X vernünftigerweise nicht mehr umfasst. Sie machen das AIS auch nicht öffentlich zugänglich, wie dies ein Händler tut, sondern nur konzernintern.

Zur Frage, ob ein Schweizer Unternehmen schon deshalb unter den AIA fallen kann, weil es sein KIS in einem Rechenzentrum in der EU betreiben lässt oder den Betrieb zwar in der Schweiz vornimmt, das Rechenzentrum aber von einem Cloud-Anbieter in der EU bereitgestellt wird, haben wir schon vorne im Zusammenhang mit der Verwendung des Outputs in der EU erörtert (Rn. 32). Es kann sich in diesen Fällen aber auch die Frage stellen, ob eine Auslagerung in eine EU-Cloud nicht als "Inbetriebnahme" des betreffenden KIS in der EU zu gelten hat, weil es hierzu genügt, dass das KIS zum erstmaligen Eigengebrauch in der EU bereitgestellt wird. Hat das Unternehmen das KIS selbst entwickeln (oder entwickeln lassen) und bringt es das KIS unter eigenem Namen zum Einsatz, wären in diesem Fall die beiden weiteren Voraussetzungen erfüllt und es läuft Gefahr, unter dem AIA als Provider des KIS zu gelten, selbst wenn es dieses nur für sich nutzt und seinen Sitz in der Schweiz hat. Um dieses Risiko zu reduzieren, sollten Schweizer Unternehmen KIS somit vorzugsweise auf Rechenzentren ausserhalb der EU betreiben, selbst wenn die Betreibergesellschaft (z.B. der Cloud-Provider) seinen Sitz selbst in der EU hat. Und noch etwas sollten Schweizer Unternehmen bedenken: Mitarbeitende, die sich beim Einsatz von AIS in der EU aufhalten und so zur Anwendbarkeit des AIA führen können (z.B. im Home-Office oder auf Reisen).

Im Unternehmenskontext kann sich auch die Frage stellen, ab welchem Moment ein Unternehmen, das ein Produkt mit einer KI-gestützten Funktionalität seinen Kunden zur Verfügung stellt, selbst als Provider und die Kunden als dessen Deployer gelten. Die Hürden sind dabei nicht sehr hoch: Nehmen wir als Beispiel eine Bank ausserhalb der EU, die ihren EU-Geschäftskunden in ihrem Online-Banking und -Trading eine KI-gestützte Analyse ihrer Portfolios anbietet; dies ist Teil der kommerziellen Dienstleistung der Bank. Die Bank wird, wenn sie diese Funktionalität selbst entwickelt hat oder entwickeln lassen hat, aufgrund ihres eigenen Einsatzes bereits als Provider gelten, zumal sie es (jedenfalls nach einem weiten Begriffsverständnis) in der EU zum Einsatz bringt (siehe dazu aber Rz. 41) und dies unter ihrem eigenen Namen geschieht.

Die Kunden, die die KI-Analyse-Funktion einsetzen, können ihrerseits zu Deployern werden und dabei dem AIA unterstellt sein, selbst wenn sich die Bank nicht darum kümmern sollte. Hierbei sind zwei Voraussetzungen zu beachten: Die Kunden müssen sich erstens in der EU befinden oder der Output der KI-Analyse in der EU verwendet werden. Sie müssen die KI-Funktion zweitens in eigener Verantwortung ("under its authority") einsetzen (siehe dazu oben). Erhält der Bankkunde somit die nötige Kontrolle über die KI-Funktion, wird er (der als Geschäftskunde nicht unter die Ausnahme für persönliche, nicht berufliche Nutzungen fällt) aus eigener Verantwortung sicherstellen müssen und wollen, dass es sich um keine verbotene KI-Praktik handelt und allenfalls anwendbare Deployer-Pflichten eingehalten werden. Die Schwierigkeit in der Praxis kann dabei sein, dass es gerade bei Anbietern aus dem EU-Ausland für EU-Deployer möglicherweise gar nicht klar ist, wo und wann in den genutzten Produkten und Dienstleistungen AIS zum Einsatz kommen und was genau sie tun.

In diesem Zusammenhang kann sich auch die Frage stellen, ob ein Provider sachlogisch nur dann vorkommen kann, wenn es auch einen Deployer gibt, dem der Provider das AIS zur Verfügung stellt. Die Antwort hierauf dürfte ein "Nein" sein. Ansonsten wären alle Anbieter, die KI-Dienste nur an Verbraucherinnen und Verbraucher in der EU anbieten, nicht vom AIA erfasst, weil solche Nutzerinnen und Nutzer kraft einer Ausnahmeregelung nicht als Deployer gelten. Die Definition des Providers setzt keinen Deployer voraus: Es genügt zum einen die Bereitstellung in der EU für den Eigengebrauch in der EU ("for own use in the Union"); um das zu erfüllen, reicht es womöglich bereits aus, dass der Anbieter die Nutzerinnen und Nutzer in der EU anspricht und sie den Dienst dort nutzen lassen, da es weiterhin der Dienst des Anbieters und somit "seine" Verwendung des AIS ist (die Schlussfolgerung, dass dies bereits ein Eigengebrauch in der EU darstellt, ist unseres Erachtens zwar nicht zwingend, dürfte aber im Hinblick auf den Schutzzweck des AIA mitunter vertreten werden; dies würde dazu führen, dass der bloss via Website einem EU-Publikum angebotene Chatbot bereits zum Eigengebrauch in der EU führen würde, d.h. ein Fernzugriff aus der EU als Gebrauch vor Ort qualifiziert; dem könnte entgegengehalten werden, dass der Gesetzgeber gerade nicht davon ausging, dass dies zur Erfassung genügt, weshalb er die Verwendung von KIS-Output in der EU als separates Anknüpfungskriterium definierte, welches hier jedenfalls beim Deployer greifen würde). Zum anderen lässt es das alternative Kriterium zur Provider-Qualifikation des Inverkehrbringens ("placing on the market") genügen, dass ein AIS "zur Verwendung auf dem Unionsmarkt im Rahmen einer Geschäftstätigkeit" ("for … use on the Union market in the course of a commercial activity") geliefert worden ist. Dieser Fall liegt hier wohl vor. Abschliessend geklärt ist aber auch diese Frage nicht.

6. Verbotene KI-Anwendungen

Acht spezifische "KI-Praktiken" sind unter dem AIA ganz verboten. Vom Verbot erfasst sind in den meisten Fällen, sowohl jene, die betreffende AIS in der EU auf den Markt oder erstmals in der EU zum Einsatz bringen als auch jene, die ein AIS so verwenden wollen (was, wie gezeigt, auch jene umfasst, die sie im Ausland nutzen, soweit der Output der AIS bestimmungsgemäss auch in der EU verwendet wird).

Die Liste der verbotenen KI-Praktiken ist zwar sehr spezifisch, aber trotzdem nicht überall trennscharf abgegrenzt formuliert:

- Verwendung von unterschwelligen, absichtlich manipulativen oder täuschenden Techniken, die darauf abzielen oder bewirken, dass das Verhalten wesentlich verzerrt wird oder die Fähigkeit der Person, eine informierte Entscheidung zu treffen, beeinträchtigt wird, falls dies zu einer Entscheidung führen kann, die mit hinreichender Wahrscheinlichkeit einen erheblichen Schaden verursacht oder verursachen kann. Keine Absicht muss hinsichtlich der Schadensverursachung vorhanden sein. Nicht erfasst sein sollen ansonsten zulässige Anwendungen im medizinischen Bereich.

- Ausnutzen von Vulnerabilitäten oder der Schutzbedürftigkeit von Personen aufgrund ihres Alters, einer Behinderung oder einer besonderen sozialen oder wirtschaftlichen Situation, um ihr Verhalten in einer Weise zu beeinflussen, diewesentlich in einer Weise zu verändern, die mit hinreichender Wahrscheinlichkeit einen erheblichen Schaden verursacht oder verursachen kann.

- Biometrische Kategorisierung, um Rückschlüsse auf die Rasse, die politische Meinung, die Gewerkschaftszugehörigkeit, die religiöse oder weltanschauliche Überzeugung, das Sexualleben oder die sexuelle Ausrichtung einer Person zu ziehen (d.h. auf der Grundlage biometrischer Daten). Es geht also darum, dass gewissermassen von "Äusserlichkeiten" auf (in diesem Fall sensible) "innere" Werte geschlossen wird, was insbesondere deshalb als verboten wird, weil es auch mit AIS unzuverlässig ist. Keine biometrische Kategorisierung ist beispielsweise die Analyse von Text einer Person, wohl aber deren Stimme. Nicht verboten ist auch der Einsatz von AIS, um biometrische Merkmale als solche zu erkennen, z.B. alle Personen mit grünen Augen.

- Bewertung oder Kategorisierung von Personen (einzeln oder in Gruppen) über einen bestimmten Zeitraum hinweg auf der Grundlage ihres Sozialverhaltens oder bekannter, abgeleiteter oder vorhergesagter persönlicher Eigenschaften, falls diese soziale Bewertung zu einer nachteiligen oder ungünstigen Behandlung führt, die in keinem Zusammenhang mit dem ursprünglichen Kontext der Daten steht oder aber im Hinblick auf ihr soziales Verhalten oder dessen Tragweite ungerechtfertigt oder unverhältnismässig ist.

- Biometrische Identifizierung aus der Ferne und in Echtzeit in öffentlich zugänglichen Räumen zum Zweck der Strafverfolgung, mit Ausnahme der gezielten Suche nach Opfern gewisser Straftaten, der Vorbeugung gewisser spezifischer Bedrohungen im Falle erheblicher und unmittelbar bevorstehender Bedrohungen oder der Lokalisierung oder Identifizierung von Verdächtigen bestimmter definierter Kategorien von Straftaten (Anhang II), vorbehaltlich zusätzlicher Bedingungen (z.B. gerichtliche Genehmigung, Erlaubnis nur für die Suche nach bestimmten Zielpersonen).

- Erstellung von Profilen oder Bewertung von Persönlichkeitsmerkmalen oder Eigenschaften von Personen, um das Risiko der Begehung von Straftaten einzuschätzen oder vorherzusagen, ausser zur Unterstützung der Risikobewertung von Personen, die an einer Straftat beteiligt sind.

- Aufbau oder Erweiterung einer Gesichtserkennungsdatenbank auf der Grundlage von ungezieltem Scraping im Internet oder CCTV-Aufnahmen (d.h. Überwachungskameras). Hier scheint der Gesetzgeber Anbieter wie "Clearview" und "PimEyes" im Blick gehabt zu haben.

- Das Ziehen von Rückschlüssen auf Emotionen (einschliesslich Absichten) von Personen am Arbeitsplatz oder in Bildungseinrichtungen, es sei denn, dies soll medizinischen oder sicherheitstechnischen Gründen dienen. Hier kommt es jedenfalls gemäss dem Text nicht darauf an, ob die Emotionserkennung auf biometrischen Daten (z.B. Stimme, Gesichtsausdruck) oder anderen Daten (z.B. Inhalt von E-Mails oder anderen Texten) basiert. Dies ist jedoch nicht vollständig klar. Denn auch bei den HRAIS, wo Systeme zur Emotionserkennung ebenfalls erfasst sind, wird im Text nicht differenziert, jedoch geht aus den Erwägungen hervor, dass jedenfalls dort nur Emotionserkennung auf Basis biometrischer Daten gemeint ist.

Zu beachten ist, dass diese Praktiken nur dann verboten sind, wenn sie mittels eines AIS ausgeführt werden. Wer also etwa eine Emotionserkennung am Arbeitsplatz einzig anhand selbst, also von Menschenhand programmierter Wenn-Dann-Regeln durchführt (keine Mustererkennung), ist nicht erfasst. Die Tatbestände sind zudem oft sehr spezifisch formuliert, so dass sich rasch Ausnahmen ergeben. Der Einsatz von AIS zur Überführung von Schülerinnen und Schülern, die bei einer Prüfung tatsächlich schummeln, ist vom Verbot der Erkennung von Emotionen und Absichten beispielsweise nicht erfasst (allerdings eine Hoch-Risiko-Anwendung).; erfasst wäre aber ein AIS, das Schüler aufspüren soll, noch bevor sie schummeln. Detektiert eine AIS die Nervosität eines Schülers, damit die Lehrperson ihn besonders im Auge behalten kann, dann wäre dies eine verbotene Praktik, weil Nervosität eine Emotion darstellt. Erfasst wären auch Lügendetektoren. Grund für das Verbot ist übrigens auch hier die Unzuverlässigkeit der Erkennung und die damit verbundene Gefahr von Ungenauigkeiten und Diskriminierung.

Auch am Arbeitsplatz sind Beispiele im Bereich der Emotionserkennung denkbar, die in der Praxis vorkommen können und keineswegs ungewöhnlich sind. Ein Beispiel ist die Analyse von Gesprächen eines Call Centers. Zur Qualitätskontrolle und für Schulungszwecke werden z.B. gerne sog. Sentiment-Analysen durchgeführt, bei denen die Stimmung der Anrufer ermittelt wird (positiv, neutral, negativ). Geschieht dies nur anhand der Stimme des Anrufers (z.B. live), so sind die Call-Center-Mitarbeitenden nicht betroffen (die Anwendung würde jedoch anderweitig vom AIA erfasst). Erfolgt die Auswertung jedoch nachträglich anhand eines Transkripts des Dialogs, so kann es je nach Programmierung vorkommen, dass in der Zusammenfassung für den Supervisor auch die Stimmung bzw. die Emotion des Call-Center-Agent angegeben wird. Dies wäre unzulässig, jedenfalls wenn nicht danach differenziert wird, ob die Emotionserkennung auf Basis biometrischer Daten erfolgt.

Wer wiederum ein AIS benutzt, um "Data Loss Prevention" (DLP) zu betreiben, führt keine verbotene Praktik aus, auch wenn der Diebstahl von Daten eine Straftat sein kann und DLP daher im weitesten Sinne auch die Beurteilung des Risikos einer Straftat umfasst, aber dies eben nicht das Ziel ist, sondern die Verhinderung eines ungewollten Datenabflusses, ganz gleich, ob es sich um eine Straftat handelt (die verbotene Praktik Nr. 6 oben zielt auf das "predictive policing" ab und nicht auf die Verhinderung von Delikten, die im Gange sind). Das AIS muss aber so funktionieren, dass es Indizien auf Datendiebstahl aufspürt (z.B. Übermittlung bestimmter geschäftlicher Dateien an eine private E-Mail-Adresse) und nicht Hinweise auf Emotionen oder Absichten eines Mitarbeitenden, einen solchen zu begehen (z.B. Suche nach Mustern, wonach der Mitarbeitende eine Wut auf seinen Arbeitgeber hat, frustriert im Job ist oder innerlich gekündigt hat, also keine Loyalität mehr aufweist). Keine Emotion ist hingegen Müdigkeit. Wer also eine KI einsetzt, um übermüdete Mitarbeitende zu erkennen, darf das. Der Einsatz von KI zur Erkennung von Stress am Arbeitsplatz ist hingegen nicht erlaubt.

Ein weiteres Beispiel: Bei der verbotenen Praktik Nr. 1 genügt es nicht, dass Personen mittels KI manipuliert werden. Es muss dies auch zu dem Zweck erfolgen, sie wesentlich in ihrem Verhalten zu beeinflussen, sie daran zu hindern, informierte Entscheidungen zu treffen, und das muss zudem zu einem Entscheid führen, der wesentlichen Schaden für die Person verursachen kann. So halten sogar die Erwägungen fest, dass "übliche und rechtmäßige Geschäftspraktiken, beispielsweise im Bereich der Werbung" ("common and legitimate commercial practices") hier nicht erfasst sind.

Etwas weniger klar ist der Fall bei Praktik Nr. 4 (Scoring), welche recht breit verstanden werden kann, weil sie lediglich eine nachteilige Behandlung voraussetzt. Das Verbot greift aber nur und erst, wenn die Daten mit dieser Behandlung, um die es geht, nichts zu tun haben oder die Schlechterbehandlung unverhältnismässig oder unberechtigt ist. Spannend wird hier zu sehen sein, ob beispielsweise KI-gestützte Funktionen, die für jeden Besucher eines Online-Shops den aufgrund seines Verhaltens aus Sicht des Anbieters optimalen Preis berechnen, erfasst sein werden. Um dem Verbot entgegenzuwirken, müsste auch hier ein System eingesetzt werden, das nicht auf Basis eines Trainings urteilt, sondern regelbasiert agiert.

Bei Praktik Nr. 4 wird sich weiter die Frage stellen, ob und wann sie KI-basierte Bonitätsbeurteilungen meint und damit verbieten würde. Die Zahlungsfähigkeit einer Person ist zwar kein soziales Verhalten und auch keine persönliche Eigenschaft, die Zahlungswilligkeit kann es aber sein. Erfasst wäre also, wer ein AIS auf den Markt bringt, welches zwecks Kreditgewährung Korrelationen zwischen dem Verhalten einer Person und ihrer mutmasslichen Zahlungsunwilligkeit aufzeigt und hierbei Daten aus einem Kontext verwendet, der mit der Zahlungswilligkeit der Person nichts zu tun hat oder deren Beizug unverhältnismässig oder ungerechtfertigt wäre. Dem würde der Anbieter einer Lösung für ein Bonitäts-Scoring entgegenhalten, dass diese auch die Zahlungsfähigkeit abdeckt. Hierauf könnte geantwortet werden, dass die Beurteilung "Zahlt seine Rechnungen mit erhöhter Wahrscheinlichkeit nicht" durchaus als "Social Score" verstanden werden kann. Diesfalls müsste zur Verwendung des AIS aufgezeigt werden, dass nur Daten verwendet werden, die im Kontext des Bezahlens von Rechnungen erhoben wurden und die Bonitätsbeurteilung tatsächlich einigermassen die richtigen trifft und die Konsequenzen vertretbar sind. Als HRAIS wäre eine solche Anwendung freilich so oder so erfasst (siehe nachfolgend).

Ob der Gesetzgeber bei Praktik Nr. 4 tatsächlich so weit gehen wollte, wie dies aus der weit gefassten Regelung wie gezeigt geschlossen werden könnte, ist nicht klar. In den Erwägungsgründen hält er jedenfalls fest, dass das Verbot "nicht die rechtmäßigen Praktiken zur Bewertung natürlicher Personen berühren [sollte], die im Einklang mit dem Unionsrecht und dem nationalen Recht zu einem bestimmten Zweck durchgeführt werden." Die kryptische Formulierung, die im Englischen nicht klarer ist, ist wohl dahingehend zu verstehen, dass er nur extreme Fälle untersagen wollte – wie sie etwa in China praktiziert werden. Die Aussage könnte so verstanden werden, dass immer dann, wenn eine Beurteilung bzw. ein Profiling einer natürlichen Person erstens datenschutz- und auch sonst rechtskonform ist (nach dem Recht der EU) und zweitens die Daten erklärtermassen (auch) zu dem spezifisch Zweck erhoben worden sind, für den sie verarbeitet werden, der AIA die Bewertung nicht verbieten will. Gibt also der erwähnte Online-Shop in seiner Datenschutzerklärung an, was er mit den Daten der betroffenen Personen tun will, auch wenn diese inhaltlich damit auf den ersten Blick nichts zu tun haben, und erfüllt er auch sonst die Vorgaben der DSGVO (soweit sie anwendbar ist), dann wäre der Einsatz eines AIS hierfür demnach nicht verboten.

7. Hoch-Risiko KI-Systeme

Als "Hoch-Risiko KI-System" (HRAIS) gelten zwei Arten von AIS. Zunächst sind es grundsätzlich jene AIS, welche nach den im Anhang I zum AIA aufgeführten EU-Regularien sind, für welche vor dem Vertrieb oder Einsatz eine Konformitätsbewertung durch einen Dritten erforderlich sind, sowie jene AIS, die als Sicherheitskomponente in solchen regulierten Produkten eingesetzt werden (als Sicherheitskomponente gelten auch solche AIS, deren Ausfall zu einer Gefährdung der Gesundheit oder Sicherheit von Mensch oder Besitz führen). Die Anforderungen des AIA ergänzen in diesen Fällen die Regeln, die für diese Produkte ohnehin gelten. Beispiele für solche Produkte sind Medizinprodukte, Spielzeug, Funkgeräte, Sportboote, Flugzeuge, Fahrzeuge, Eisenbahnen oder Aufzüge.

Weiter gelten als HRAIS all jene AIS, die in einem weiteren Anhang des AIA aufgeführt sind. Wie schon bei den verbotenen Praktiken sind auch diese AIS sehr spezifisch definiert, weshalb die Liste regelmässig überprüft und nötigenfalls angepasst werden sollte. Derzeit umfasst die Liste folgende Anwendungen. Entscheidend ist jeweils, ob ein AIS bestimmungsgemäss für den betreffenden Zweck eingesetzt werden soll. Es werden im betreffenden Annex meist die Anwendungsgebiete definiert, und dann die einzelnen, erfassten Fälle hohen Risikos näher beschrieben:

- Biometrische Fernidentifizierung mittels KI, die über die blosse Authentifizierung hinausgeht, oder biometrische Kategorisierung mittels KI, welche sensible oder geschützte Merkmale oder Eigenschaften verwenden, die aus solchen abgeleitet wurden. Gemeint sind insbesondere Anwendungen zur Gesichtserkennung über Kamerabilder, die in einer Zentrale verarbeitet werden, aber nicht Systeme zur biometrischen Zugangskontrolle oder Systeme, die sicherstellen sollen, dass nur autorisierte Personen Zugriff auf ein Computersystem erhalten.

- Erkennung von Emotionen oder Absichten auf der Grundlage biometrischer Daten mittels KI. Anhang III erwähnt nur "Emotionen", nicht Absichten ("intentions"), aber letztere werden in der Begriffsdefinition und in den Erwägungen immer mitgenannt. Es spielt keine Rolle, ob Personendaten bearbeitet werden oder nicht. Beispiele könnten sein, die Emotionserkennung bei einem Verkaufsautomaten, einem Videospiel oder einem System zur medizinischen Diagnose. Als Emotionen gelten beispielsweise Glück, Trauer, Wut, Überraschung, Ekel, Verlegenheit, Aufregung, Scham, Verachtung, Zufriedenheit und Vergnügen. Die Erkennung von Schmerzen und Müdigkeit ist hingegen nicht erfasst, ebenso nicht das Erkennen von Gesten und Bewegungen, beispielsweise zur Steuerung eines Systems. Die Erwägungen halten ausserdem fest, dass biometrische Systeme, die ausschließlich dazu bestimmt sind, um Massnahmen zur Cybersicherheit und zum Schutz personenbezogener Daten durchführen zu können, nie als HRAIS gelten sollen. Die Regelung zur Emotionserkennung ist insofern missverständlich, als dass in Anhang III von "KI-Systemen, die bestimmungsgemäß zur Emotionserkennung verwendet werden sollen" die Rede ist und nicht vom definierten Begriff "Emotionserkennungssystem". Das ist insofern von Belang, als letzterer Begriff zwingend voraussetzt, dass die Erkennung der Emotion auf der Grundlage von biometrischen Daten einer Person erfolgt, also beispielsweise aufgrund ihres Gesichtsausdrucks, ihrer Stimme oder ihrer Bewegungen. Gemeint ist aber in beiden Fällen dasselbe, d.h. auch die Regelung zu den HRAIS meint Emotionserkennung nur auf Basis biometrischer Daten, wie aus den Erwägungsgründen hervorgeht. Das kann von erheblicher praktischer Relevanz sein, wenn es um eine Emotionserkennung auf der Basis des allgemeinen, nicht personenbezogenen Bedeutungsgehalts von Texten einer Person geht. Wenn also im oben erwähnten Call-Center-Beispiel für eine Sentiment-Analyse eine Unterhaltung zunächst transkribiert und erst in dieser Form von einem AIS analysiert wird, wäre dies kein HRAIS, wenn der Inhalt dessen, was jemand sagt, nicht mehr als ein biometrisches Datum gilt. Als ein solches gelten personenbezogene Daten zu den physischen, physiologischen oder verhaltenstypischen Merkmalen einer natürlichen Person. Um eine Text-basierte Sentiment-Analyse als Emotionserkennung zu erfassen, müsste gezeigt werden, dass die von einer Person verwendeten Aussagen und Formulierungen "verhaltenstypische" Merkmale sind und für die Sentiment-Analyse ausgewertet werden. Dem wird normalerweise nicht so sein. Gemeint sind hier unseres Erachtens konstante, individuelle, messbare und bei jeder Person vorkommende Merkmale dieser Person wie ihre Stimme (d.h. bestimmte Aspekte davon, wie Akzent oder Betonungen), Unterschrift und Lippenbewegungen, ihr Tippverhalten auf Tastaturen oder ihre Gangdynamik. Bei Text wäre ein solches Merkmal eine für eine bestimmte Person charakteristische Formulierung wie z.B. eine bestimmte Art und Weise, wie sie ihre E-Mails "unterzeichnet" (in Analogie zur Unterschrift als verhaltenstypisches Merkmal). Der auf Basis allgemeiner, nicht personenbezogener Erfahrungswerte ermittelte Bedeutungsgehalt von geschriebenem Text ist unserer Ansicht nach jedoch kein solches Merkmal einer bestimmten Person und darf daher für eine Emotionserkennung wie im Beispiel der Sentiment-Analyse verwendet werden (z.B. Verärgerung, wenn die Person sagt, sie sei verärgert oder Formulierungen verwendet, die dies nach allgemeinem Sprachgebrauch ausdrücken, wie z.B. "Das kann doch nicht Ihr Ernst sein!"). Würde hingegen ein KI-Modell auf Texten einer bestimmten Person trainiert, die nach ihrem jeweiligen Gemütszustand bezeichnet sind, und würde dieses Modell später eingesetzt, um die Emotionen eben dieser Person anhand von weiteren Texten dieser Person zu ermitteln, quasi indem es aufgrund seines personenbezogenen Trainings "zwischen den Zeilen" lesen kann, läge eine Emotionserkennung im Sinne des AIA vor. Wo genau die Grenze verläuft, bleibt freilich auch damit nicht ganz klar.

- KI soll als Sicherheitsbauteil bei der Verwaltung und dem Betrieb kritischer digitaler Infrastrukturen (wie z.B. gewisse Internet-, Telekom-, Kommunikations-, Cloud-Computing- und Rechenzentrums-Dienste), im Strassenverkehr oder bei der Versorgung mit Wasser, Gas usw. eingesetzt werden (nicht aber KI einzig zur Cybersicherheit).

- Einsatz in der allgemeinen und beruflichen Bildung, sofern (i) der Zugang, die Zulassung oder die Zuweisung zu Bildungsangeboten durch KI bestimmt werden soll, (ii) KI zur Bewertung der Lernergebnisse oder des (für den Zugang zur Bildung nötigen) Bildungsniveaus von Personen eingesetzt werden soll oder (iii) KI zur Überwachung oder Erkennung von verbotenem Verhalten bei Prüfungen eingesetzt werden soll.

- Einsatz im Bereich Beschäftigung und Arbeitnehmer, soweit (i) KI für die Einstellung oder Auswahl von sich auf eine Stelle bewerbenden Personen oder für die Platzierung von Stellenangeboten verwendet wird oder (ii) KI verwendet wird, um Entscheidungen zu treffen, die sich auf die Beschäftigungsbedingungen auswirken oder Beförderungen oder die Beendigung des Arbeitsverhältnisses betreffen, um Arbeit zuzuweisen auf der Grundlage von Verhalten oder anderen persönlichen Merkmalen und um Leistung und Verhalten zu beobachten und zu bewerten.

- KI wird verwendet, um (für oder als Behörde) zu beurteilen, ob einer bestimmten Person wesentliche öffentliche Unterstützungsleistungen und Dienste, einschliesslich der Gesundheitsversorgung, zur Verfügung stehen oder weiterhin zur Verfügung stehen werden.

- KI wird zur Bewertung der Kreditwürdigkeit einer Person oder Bestimmung ihres Bonitäts-Scores verwendet werden, jeweils ausser zur Aufdeckung von Finanzbetrug.

- KI wird verwendet, um Notrufe von Personen zu bewerten und zu klassifizieren, oder um Notrufe oder Notfalldienste oder die medizinische Versorgung zuzuweisen oder zu triagieren. Die Verwendung von KI für medizinische Zwecke (wie z.B. die Beurteilung von Patienten) ist als solche nicht ausdrücklich als Anwendungsfall aufgeführt. Wer jedoch eine Software oder ein Gerät anbietet, welches KI beispielsweise für Diagnosezwecke verwendet oder zur Behandlung, wird typischerweise über die Regulierung von Medizinprodukten erfasst sein. Nicht ganz klar ist, ob die Regelung, wonach derjenige zum Provider wird, der ein "normales" AIS zu einem HRAIS umfunktioniert, im Fall greift, in welchem beispielsweise ein Arzt "ChatGPT" benutzt, um z.B. Aufzeichnungen seiner Patienten zu analysieren.

- KI wird für Risikobewertungen und die Preisgestaltung von Lebens- oder Krankenversicherungen verwendet.

- Verwendung zu Strafverfolgungszwecken, wenn (i) KI zur Bewertung des Risikos einer Person, Opfer einer Straftat zu werden, verwendet werden soll, (ii) KI als Lügendetektor oder ähnliches Instrument verwendet werden soll oder (iii) KI zur Feststellung der Zuverlässigkeit von Beweismitteln verwendet werden soll (in jedem Fall mit Ausnahme der oben genannten verbotenen Praktiken).

- Verwendung zu Strafverfolgungszwecken, wenn (i) KI dazu dient, das Risiko einer Straftat oder einer erneuten Straftat einer Person nicht nur auf der Grundlage eines (automatisierten) Profils zu bewerten, (ii) KI dazu dient, persönliche Merkmale oder Eigenschaften oder frühere kriminelle Verhaltensweisen von Personen oder Gruppen zu bewerten, oder (iii) KI zur Erstellung von Profilen von Personen im Rahmen der Aufdeckung, Untersuchung oder Verfolgung von Straftaten verwendet werden soll.

- Im Migrations-, Asyl- und Grenzkontrollwesen, soweit (i) KI als Lügendetektor oder ähnliches Werkzeug verwendet werden soll, (ii) KI zur Bewertung des Risikos von Personen, die in die EU einreisen oder dies tun wollen, verwendet werden soll, (iii) KI zur Unterstützung der Prüfung von Anträgen auf Asyl, Visa, Aufenthaltsgenehmigungen und damit zusammenhängenden Beschwerden sowie zur Bewertung der damit zusammenhängenden Beweise verwendet werden soll, (iv) KI zum Aufdeckung, Anerkennung oder Identifizierung von Personen verwendet werden soll, ausser zur Überprüfung von Reisedokumenten.

- KI wird von einer Justizbehörde oder in deren Auftrag oder im Rahmen einer alternativen Streitbeilegung verwendet, um die Justizbehörde bei der Ermittlung und Auslegung von Sachverhalten und Rechtsvorschriften und deren Anwendung auf einen bestimmten Fall zu unterstützen.

- KI wird zur Beeinflussung des Ergebnisses einer Wahl oder einer Abstimmung eingesetzt, jedoch nicht, wenn Personen dem Ergebnis der KI nicht unmittelbar ausgesetzt sind (z.B. KI-Systeme, die zur Organisation, Optimierung und Strukturierung der Verwaltung oder Logistik politischer Kampagnen eingesetzt werden).

In der Praxis privater Unternehmen von Relevanz sein werden vor allem die Fälle 2, 3, 4, 5, 7, 8 und 9 sein. Die meisten Anwendungsfälle haben wir bisher im Arbeitsbereich und Bildungssektor gesehen. Die Vorselektion oder Bewertung von Stellenbewerbern (z.B. wie gut sie in das gesuchte Profil passen oder welche Erkenntnisse sich aus dem Lebenslauf ziehen lassen) ist eine solche Anwendung, selbst wenn letztlich Menschen die Entscheidung treffen. Extremere Anwendungsfälle haben wir im Sportbereich gesehen, wo bereits heute AIS zur Beurteilung und Ausbildung von Profi- und teilweise auch Amateur-Athleten eingesetzt werden, zu denen die betreffenden Vereine und Organisationen nicht selten ein Arbeits- oder Ausbildungsverhältnis stehen. Fragen stellen sich in der Praxis immer wieder auch in Bezug auf Systeme, welche Unternehmen zur Cybersicherheit (z.B. "Endpoint Detection and Response", EDR) und "Data Loss Prevention" (DLP) einsetzen: Sie überwachen den Netzwerkverkehr und das Verhalten der Mitarbeitenden und schlagen Alarm, wenn ungewöhnliche Vorkommnisse beobachtet werden, die auf Eindringlinge, Datendiebstahl oder sonstige Regelverstösse beobachtet werden. Als Erkennung von Emotionen und Absicht gelten Massnahmen zur Cybersicherheit zwar wie erwähnt nicht, jedoch ist fraglich, ob solche Systeme nicht der "Beobachtung … des Verhaltens von Personen in … Beschäftigungsverhältnissen" dienen. Dies dürfte tendenziell der Fall sein, jedenfalls wenn die Ausrichtung dieser Systeme primär nach innen gerichtet ist, wie dies beispielsweise bei einem DLP ist, welches den unerwünschten Datenabfluss durch Mitarbeitende erkennen und unterbinden soll (während z.B. EDR-Systeme primär auf Anzeichen von externen Bedrohungen wie Ransomware-Angriffe und Malware achten). Den Erwägungen zufolge erfolgt die Klassifizierung als HRAIS, weil die Überwachung der Leistung und des Verhaltens von Beschäftigten "deren Grundrechte auf Datenschutz und Privatsphäre" untergraben kann, was bei DLP-Systemen sein kann. Gegen die Klassifizierung als HRAIS könnte eingewendet werden, dass mit Verhalten die Beobachtung des regulären Verhaltens eines Beschäftigten gemeint ist, nicht das Aufspüren eines ganz ausnahmsweise vorkommenden Fehlverhaltens, jedenfalls wenn der Alarm nur dann anschlägt, wenn bestimmte (nicht mittels KI-ermittelte) Schwellenwerte oder Trigger überschritten sind. Zu erwähnen ist schliesslich noch, dass der AIA auch eine «de minimis»-Regelung für HRAIS kennt. Sie kommt dann zum Tragen, wenn gezeigt werden kann, dass ein AIS kein erhebliches Risiko der Beeinträchtigung in Bezug auf die Gesundheit, Sicherheit oder Grundrechte natürlicher Personen birgt, indem es unter anderem das Ergebnis einer Entscheidungsfindung nicht wesentlich beeinflusst. Dann liegt kein HRAIS vor. Art. 6(3) AIA zählt hierzu einige Fälle auf, in welchen das so sein soll, etwa wenn ein KI-System nur eine eng gefasste Aufgabe durchführt oder bestimmte abgeschlossene Tätigkeiten betrifft. Will ein Anbieter diese Regelung beanspruchen, muss er dies vor Inverkehrbringen und Inbetriebnahme dokumentieren. Der Registrierungspflicht für HRAIS unterliegt er trotzdem.

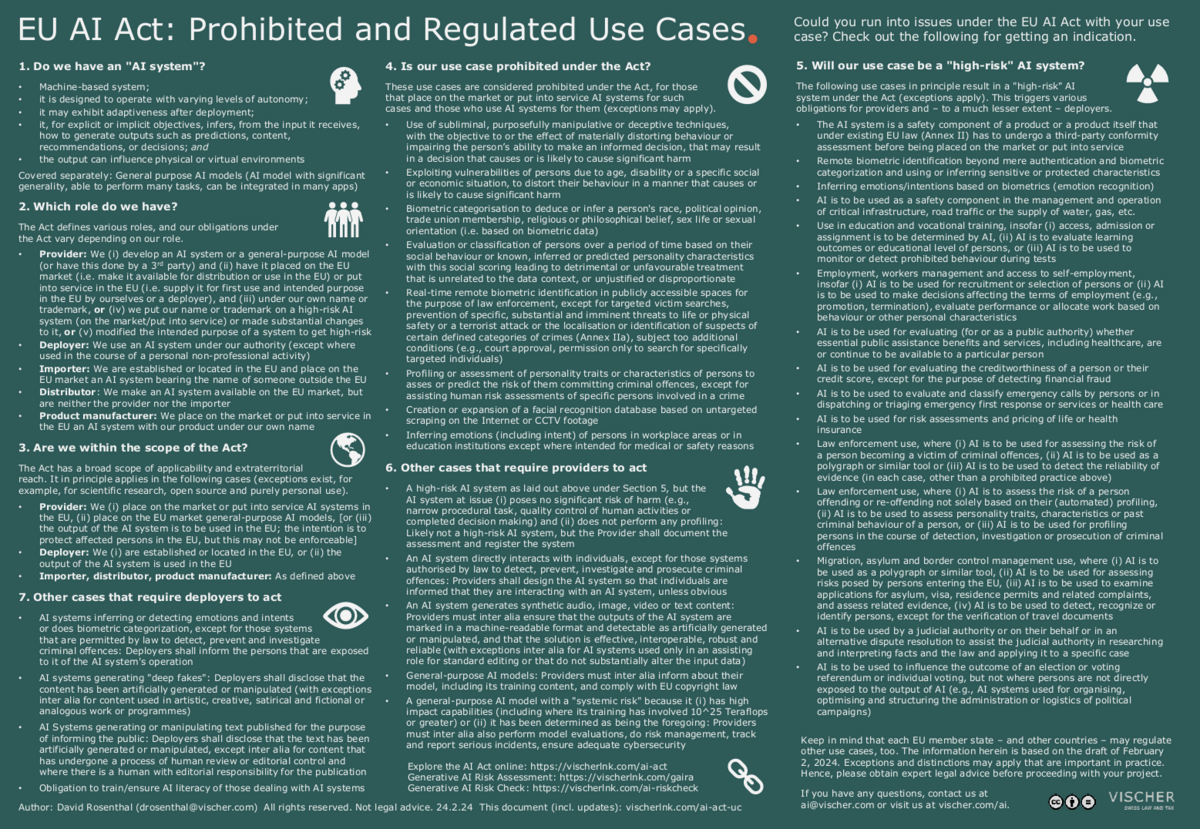

Der folgende One-Pager gibt einen Überblick über diese und die weiteren Anwendungsfälle und bisher diskutierten Definitionen des AIA (nur auf Englisch):

Hier anklicken für die Grafik (nur auf Englisch verfügbar)

Liegt ein solches HRAIS vor, hat vor allem der Provider eine ganze Reihe von Aufgaben zu erfüllen, da primär er dafür verantwortlich ist, dass die Vorgaben aus Kapitel 2 der Regelungen zu den HRAIS in Bezug auf diese erfüllt werden. Diese Vorgaben für HRAIS sind:

- Es muss ein eingehendes Risikomanagement betrieben werden, d.h. insbesondere Risikobeurteilungen, die über den gesamten Lebenszyklus des HRAIS wiederholt werden, mit entsprechenden Tests des HRAIS und Massnahmen, um die identifizierten Risiken zu kontrollieren (vgl. hierzu das Open-Source-Werkzeug GAIRA);

- Die Daten, die für Training, Validierung und Tests verwendet werden, müssen bestimmten Qualitätskriterien genügen und müssen Gegenstand einer weitreichenden Data Governance sein, um beispielweise Bias, Fehler und Lücken zu erkennen;

- Es muss eine detaillierte technische Dokumentation zum HRAIS erstellt und nachgeführt werden, die auch die Erfüllung der Vorgaben belegt;

- Das HRAIS muss das, was es tut, automatisch in Logs angemessen protokollieren, damit sein korrektes Funktionieren über Zeit überwacht werden kann;

- Das HRAIS muss so ausgestaltet sein und mit Nutzungsanweisungen und weiteren Hinweisen geliefert werden, dass seine Anwender es richtig handhaben, seinen Output richtig verstehen und einschätzen können sowie vom Menschen überwacht und kontrolliert werden kann (was u.a. umfasst, dass das HRAIS jederzeit sicher gestoppt werden kann und in einer Weise zur Verfügung gestellt wird, dass Menschen dem HRAIS nicht einfach vertrauen);

- Das HRAIS muss angemessen genau und zuverlässig arbeiten (wobei vorgesehen ist, dass die Europäische Kommission die Entwicklung entsprechender Standards fördern soll), und es muss angemessen fehlertolerant sein;

- Das HRAIS muss über eine angemessene Sicherheit verfügen, insbesondere, um es gegen Angriffe von Dritten zu schützen, sowohl im Bereich der klassischen Informationssicherheit als auch bei KI-spezifischen Angriffen (siehe Teil 6 unserer Blogs-Serie).

Um die Einhaltung dieser Anforderungen nachzuweisen und sicherzustellen und die Aufsicht zu ermöglichen, müssen Provider:

- Eine entsprechende Dokumentation führen (bis zehn Jahre nach Inverkehrbringen oder Inbetriebnahme); den zuständigen Behörden sind auf Anfrage die nötigen Nachweise zu erbringen;

- Ein Qualitätsmanagementsystem vorweisen; hat der Provider Grund zur Annahme, dass das HRAIS nicht den Anforderungen entspricht, sind unverzüglich die nötigen Korrekturmassnahmen zu treffen (einschliesslich Rückrufe) und darüber zu informieren;

- Die von ihren HRAIS im Einsatz generierten Logs aufbewahren (soweit sie sie haben, und zwar mindestens sechs Monate);

- Das HRAIS in einer EU-Datenbank registrieren (ausser jene, die im Rahmen von kritischen Infrastrukturen eingesetzt werden);

- Eine Konformitätsbeurteilung durch einen entsprechenden Dritten vornehmen lassen;

- Das HRAIS mit einem Konformitätszeichen ("CE") und ihren Kontaktangaben versehen;

- Ein System betreiben, mit welchem sie das HRAIS nach dem Inverkehrbringen in Bezug auf technische Entwicklungen und Risiken beobachten können (sog. Post-Market Monitoring-System); und

- Eine Untersuchung sowie eine Meldung an die Aufsichtsbehörden vornehmen, wenn von einem HRAIS ein Risiko für die Gesundheit, die Sicherheit oder die grundlegenden Rechte von betroffenen Personen ausgeht oder es zu einem ernsthaften Zwischenfall kommt.

Ein Provider, der selbst nicht in der EU ansässig ist, dort aber ein HRAIS anbietet, muss einen Vertreter in der EU bezeichnen ("Bevollmächtigter"), der über die nötigen Unterlagen verfügt, damit die EU-Behörden darauf zugreifen können. Speziell daran: Er ist selbstständig verpflichtet, das Mandat niederzulegen und die Aufsichtsbehörde zu informieren, falls er Grund zur Annahme hat, dass der Provider seinen Pflichten nach dem AIA nicht nachkommt. Auch den Importeuren und Distributoren von HRAIS kommen bestimmte Pflichten zu.

Auch jene, die ein HRAIS "nur" in eigener Verantwortung einsetzen, also die Deployer, haben Pflichten unter dem AIA. Sie müssen insbesondere sicherstellen, dass:

- Das HRAIS gemäss der Nutzungsanweisungen verwendet wird;

- Das HRAIS von qualifizierten Menschen überwacht wird;

- Die Logs, die das HRAIS automatisch erstellt, mindestens sechs Monate aufbewahrt werden;

- Etwaiger Input für das HRAIS im Hinblick auf den Zweck geeignet und repräsentativ ist;

- Der Provider im Rahmen von dessen Post-Market-Monitoring-Systems über den Betrieb des HRAIS informiert;

- Die Aufsichtsbehörde und der Provider (und ggf. seinen Händler) informiert wird, wenn Grund zur Annahme besteht, dass von einem HRAIS ein Risiko für die Gesundheit, die Sicherheit oder die grundlegenden Rechte von betroffenen Personen ausgeht; – hierzu ist das HRAIS im Betrieb zu überwachen; es muss mit der Aufsichtsbehörde zusammengearbeitet werden;

- Beim Einsatz von HRAIS am Arbeitsplatz die betroffenen Mitarbeitenden darüber informiert sind;

- Betroffene Personen informiert sind, wenn ein HRAIS für sie betreffende Entscheidungen verwendet wird, selbst wenn das HRAIS nur unterstützend zum Einsatz kommt (dies geht somit weiter als unter der DSGVO).; und

- Eine Grundrechte-Folgenabschätzung durchgeführt (allenfalls in Kombination mit einer Datenschutz-Folgenabschätzung) und der Aufsichtsbehörde mitgeteilt worden ist, sofern es sich beim Deployer um eine Stelle des öffentlichen Rechts, um eine private Stelle, die "öffentliche Dienste" erbringt, oder um den Betrieb eines HRAIS zur Kreditwürdigkeitsprüfung, der Berechnung eines Bonitätsscores oder der Risikobewertung oder Preisbildung im Bereich von Lebens- und Krankenversicherungen handelt; ob "öffentliche Dienste" auch rein privatrechtliche Tätigkeiten meint, ist nicht völlig klar, aber es ist aufgrund der Erwägungen davon auszugehen; erwähnt werden Dienste, die im öffentlichen Interesse, etwa in den Bereichen Bildung, Gesundheitsversorgung, Sozialdienste, Wohnungswesen und Justizverwaltung erbracht werden.

Diese Pflichten sind nicht abschliessend. Der AIA gibt in einer Art Generalklausel selbst bei rechtskonform eingesetzten HRAIS der Marktaufsicht die Kompetenz, weitere Massnahmen anzuordnen, falls dies zum Schutz der Gesundheit oder Sicherheit der Personen, deren grundlegender Rechte oder anderer öffentlicher Interessen erforderlich sein sollte.

Ferner sieht der AIA analog zur DSGVO eine Art Auskunftsrecht für betroffene Personen in der EU (nicht aber der Schweiz) vor, wenn ein Deployer auf Basis des Outputs eines HRAIS eine Entscheidung trifft, die auf die Person rechtliche oder vergleichbar wesentliche, für ihre Gesundheit, Sicherheit oder grundlegende Rechte nachteilige Auswirkungen hat. Sie kann dann verlangen, dass der Deployer ihr erklärt, welche Rolle dem HRAIS im Entscheid zugekommen ist und was die wesentlichen Elemente des Entscheids waren. Das gilt für alle HRAIS der oben aufgezählten 15 Kategorien, ausgenommen Nr. 2. Die Ansprüche gemäss DSGVO bleiben vorbehalten; sie sind insofern enger, als sie sich auf vollständig automatisierte Entscheide beziehen.

Diese Pflichten können aufgrund der extraterritorialen Geltung des AIA für Deployer von HRAIS auch für Unternehmen ausserhalb der EU von Bedeutung sein, selbst wenn der Provider sich nicht in der EU befindet, der Output des HRAIS aber in der EU verwendet wird (siehe oben). Ob und wie gut diese Pflichten beispielsweise gegen Unternehmen in der Schweiz durchgesetzt werden können und werden, ist eine andere Frage. Es ist – wie schon im Falle der DSGVO – eher nicht damit zu rechnen, da dem auch rechtliche Schranken im Schweizer Recht entgegenstehen. Stellvertretende Sanktionen gegen den korrekt handelnden EU-Vertreter dürften dagegen nicht möglich sein.

8. Regelungen für KI-Modelle

Erst spät im Gesetzgebungsprozess wurde der AIA auch um Regelungen für Provider bestimmter KI-Modelle erweitert (die Rolle des Deployers gibt es hier nicht). Allerdings sind nur für unterschiedlichste Zwecke einsetzbare Modelle ("general purpose", "KI-Modelle mit allgemeinem Verwendungszweck") erfasst (GPAIM). Wie genau sich diese gegenüber anderen Modellen abgrenzen, ist allerdings nicht klar. So könnte vertreten werden, dass ein Modell nur zur Transkription wie "Whisper" oder eines nur für Übersetzungen kein GPAIM ist. Ist ein GPAIM durch Fine-Tuning auf bestimmte Themen wie z.B. rechtliche Fragen "spezialisiert" worden, wird es aber vermutlich weiterhin als GPAIM gelten, weil es sich nach wie vor für viele unterschiedliche Anwendungen einsetzen lässt.